Analyse de logs pour augmenter son trafic SEO : un outil gratuit !

7 commentaires

Je vais commencer par les bases : un levier de trafic potentiel important, c’est le trafic SEO, c’est-à-dire depuis Google, et plus spécifiquement issu des résultats gratuits que nous appelons « naturels ». Ce sont les résultats hors AdWords.

Nos clients ne veulent qu’une chose, augmenter leur trafic SEO et donc le nombre de mots clefs bien positionnés dans Google ! Je vous invite à découvrir l’analyse de logs qui permet de trouver rapidement des optimisations à mettre en place sur votre site afin d’augmenter votre visibilité !

Comprendre de quoi on parle

L’analyse de logs est complexe en soi et obtenir les logs de son client est souvent laborieux. Exploiter les fichiers ensuite demande une certaine expertise !

Dans cet article, je vous propose un outil gratuit, rapide à mettre en place et des indicateurs pour trouver des chantiers de croissance.

Comprendre qu’est-ce qu’un « log »

Chaque site internet enregistre 100% des pages visitées par les internautes, et donc aussi les pages visitées par Google et ses robots, appelés « GoogleBot ». Ce « log » ou « journal » enregistre tout ! Même dans le détail : les images appelées pour l’affichage de la page, les fichiers CSS, JS.

Bref, ici, c’est le passage de Google qui nous intéresse. Attention, les robots de Google sont parfois spécifiques : un qui collecte des informations liées aux compatibilités mobiles, ou aux images… Mais globalement, nous allons simplifier le sujet et partir du principe qu’il n’en existe qu’un !

Analyse de logs : deux possibilités différentes et complémentaires

Pour rappel, l’analyse de logs est possible « à un instant T » : on récupère 15 jours le log en général, mais cela dépend de votre « fenêtre de crawl », notion que je ne vais pas développer ici afin de ne perdre personne ! Cette analyse est donc un audit SEO complet et qui permet de chercher un maximum d’indicateurs/KPIs susceptibles de cacher un chantier de croissance de votre trafic.

Sinon, on peut, avec un outil, récupérer les logs en temps réel et monitorer. Par exemple, en installant un script sur le serveur comme Elasticsearch, Logstash & Kibana par exemple.

Un exemple de chantier de croissance issu d’une analyse de logs

Pour commencer, rappelons qu’une analyse de ce type est longue et s’adresse à des sites avec au moins plus de 1000 pages. Ce nombre est arbitraire, mais disons que plus le site est volumineux, plus l’analyse sera payante (à condition d’exiger un consultant sénior avec minimum 6 ans de SEO derrière lui).

Exemple méconnu : le budget de crawl

Je pose souvent la question lors d’un entretien, à quoi sert un « robots.txt »… Je suis souvent étonné des réponses. Un robots.txt permet de couper le passage de GoogleBot sur des parties du site que votre consultant SEO juge sans potentiel de visites SEO. Si vous identifiez des pages/catégories de pages sans potentiel SEO, par exemple sans contenu, il faut empêcher GoogleBot de parcourir ces pages. (Attention, contrairement aux idées reçues, cette action ne supprime pas les pages de l’index de Google si le moteur les a déjà retenues dans son index… il faudra partir sur une balise noindex).

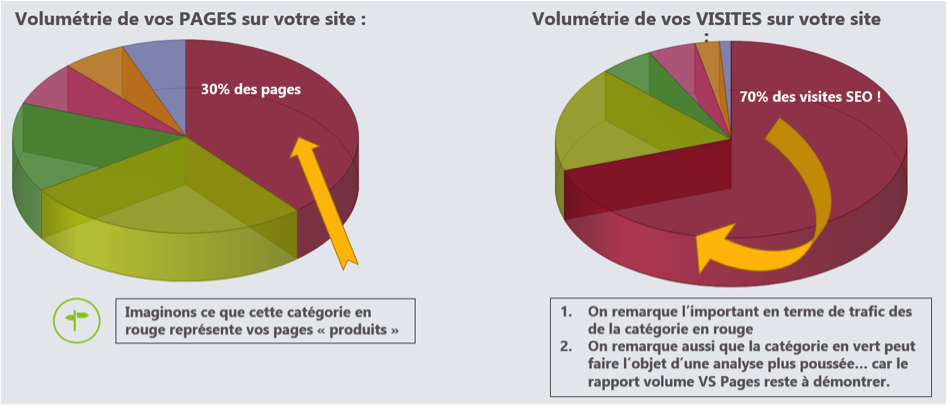

Bref, pour trouver un chantier de croissance, il faut comparer le volume des pages que GoogleBot parcourt aux pages actives, c’est-à-dire les pages qui ont généré au moins une visite SEO.

Dans cet exemple, le camembert de gauche représente la volumétrie des pages par catégorie sur le site d’un client et la droite le trafic SEO généré par ces mêmes catégories.

Les autres exemples de chantiers de croissance cachés dans les logs ne manquent pas :

- Optimiser les Latence et temps de chargement

- Mieux gérer pagination, la navigation à facettes, et les paramètres d’URLs !

- Trouver les pages orphelines (hors maillage interne du site)

Etc… C’est long, mais payant !

Comment automatiser les logs et avoir un monitoring en temps réel gratuitement ?

Voici un script très utile pour convertir Google Analytics en analyseur de logs : http://sourceforge.net/projects/galvanize/. Ce script permet d’envoyer un hit quand GoogleBot passe sur votre site. Pour cela, l’action se passe côté serveur, en PHP.

- Il faut donc télécharger galvanize : http://sourceforge.net/projects/galvanize/

- Créer une propriété sous GA à mettre sur la variable : $GA_UA = ‘UA-XXXXXXX’

- Et copier ce code sur un fichier présent sur toutes les pages de votre site :

Par exemple sur wordpress, wp-config.php est parfait.

$URL = curPageURL();

if (empty($URL)) $URL = $url;

$Label = $ip.' - '.$ua;

// que googlebot

// Logs de l’année

if(ereg(« /2017/ », $url) AND $bot == ‘Googlebot’) $GA->trackEvent(‘Crawl par année’, « 2017 », $URL, $Value = NULL, $PageTitle = NULL);

if(ereg(« /2016/ », $url) AND $bot == ‘Googlebot’) $GA->trackEvent(‘Crawl par année’, « 2016 », $URL, $Value = NULL, $PageTitle = NULL);

if(ereg(« /2015/ », $url) AND $bot == ‘Googlebot’) $GA->trackEvent(‘Crawl par année’, « 2015 », $URL, $Value = NULL, $PageTitle = NULL);

}

elseif(ereg("bot", ua))

{

//inclusion de galvanize

include_once('Galvanize.php');

$GA = new Galvanize($GA_UA);

$URL = curPageURL();

$GA->trackEvent('@Bot a verifier', $ua, $ip, $Value = NULL, curPageURL(), $PageTitle = NULL);

}

?>

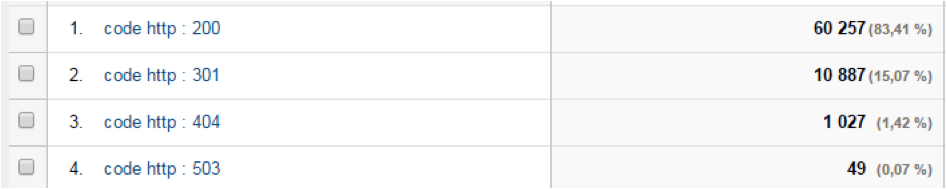

On remarque ici qui l’on peut catégoriser le crawl de GoogleBot par URL :

if(ereg(« /2017/ », $url) AND $bot == ‘Googlebot’) $GA->trackEvent(‘Crawl par année’, « 2017 », $URL, $Value = NULL, $PageTitle = NULL);

Cette ligne va donc isoler les urls comprenant la chaîne « /2017/ » dans l’event « Crawl par année » puis « 2017 ».

J’ai ajouté une ligne pour enregistrer le passage d’autre robots :

$GA->trackEvent('@Bot a verifier', $ua, $ip, $Value = NULL, curPageURL(), $PageTitle = NULL);

Pour vous permettre de mettre à jour la liste des events par robots.

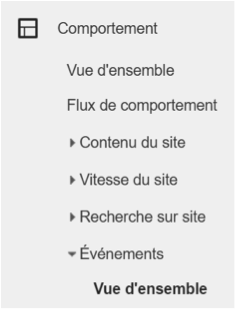

Donc, les premières lignes vont gérer des « events » Google à retrouver dans « comportement » puis « événements » :

Vous pouvez également retrouver le passage de GoogleBot au Globale :

Grâce à la ligne : if ($bot == « Googlebot ») $GA->trackPageView();

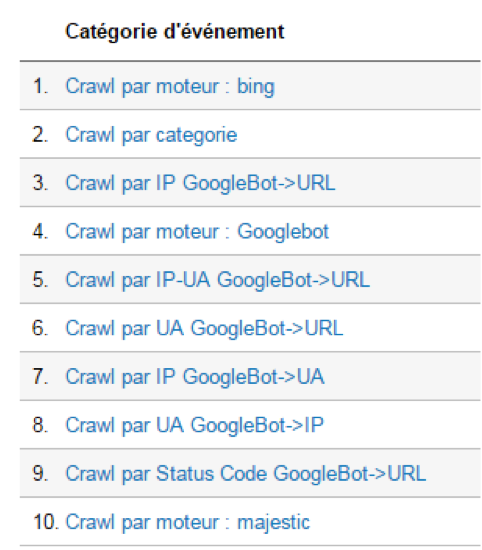

Je laisse libre votre imagination pour tracker les bons KPI. Voici un aperçu de ce que je suis de mon côté :

A vous de modifier/ajouter du code comme je l’ai fait pour suivre par exemple, les « status code » des pages :

En conclusion, ce tips ne permet pas de faire une analyse de logs très poussée, mais c’est une bonne base (gratuite) pour suivre une migration par exemple.

Vous souhaitez en savoir plus sur la mise en place d’une stratégie SEO ?

N'hésitez pas à nous contacter dès à présent !

Merci pour cet article très intéressant et pour les astuces.

En analyseur de logs complètement gratuit, il existe également OnCrawl ELK à télécharger sur Github https://github.com/cogniteev/oncrawl-elk

Il permet de suivre l’activité des bots, de recevoir des alertes, d’analyser les performances des pages et notamment des pages actives.

N’hésitez pas à tester !

Très bonne journée

Article très intéressant sur une face parfois oubliée du référencement. Je ne connaissais pas Galvanize, je vais vite tester 😉

Très intéressant, à tester !

Merci, c’est grâce à cet article que je me suis penché sur l’analyse de logs 😉

Nous avons même rédigé un tuto pour utiliser goaccess http://www.netick.fr/blog/analyse-de-logs.html

Si ça peut aider ….

Sympa cet article.

C’est vrai qu’on a souvent tendance à oublier les analyses de logs alors que ça a super valeur ajoutée. Mais c’est parfois dur à obtenir au niveau des clients malheureusement…

Sinon pour WordPress, tu as aussi cette solution avec un Plugin de sécurité. https://www.svplim.fr/wordfence-crawler-wordpress/. J’ai testé et cela m’a permis de découvrir beaucoup de crawl de pages inutiles..

Excellent article. Merci !